Analyse complexe

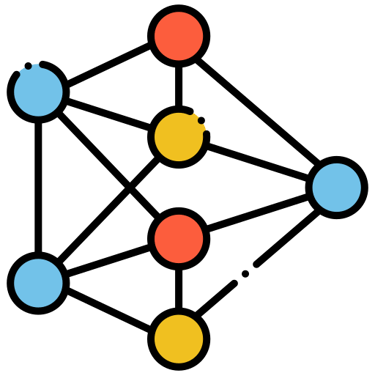

Les projets qui entrent dans cette catégorie sont toutes les analyses dont les données ne sont pas tabulaires mais définies comme "complexes" (les images, les vidéos, le langage, les sons, etc.) et nécessite une modélisation par Deep Learning.

Analyse textuelle

L'analyse textuelle consiste à extraire des informations significatives à partir de données textuelles, telles que des documents, des articles de presse, des publications sur les réseaux sociaux, etc. Cette analyse implique l'utilisation de techniques statistiques et de traitement du langage naturel (NLP) pour explorer, analyser et interpréter le contenu textuel.

Les méthodes couramment utilisées incluent la classification de texte, l'extraction de thèmes, l'analyse de sentiment, et la modélisation de sujet. L'analyse textuelle permet de découvrir des tendances, des opinions, des sentiments et des relations dans les données textuelles, ce qui peut être utile pour la prise de décision, la veille concurrentielle, le service client, et bien d'autres applications.

Cette catégorie d'analyse ouvre notamment la porte aux données moins utilisées que sont les retours clients, or il n'y a rien de plus précieux pour en apprendre d'avantage sur son entreprise que de comprendre les retours écrits ou oraux des clients ou utilisateurs. L'analyse textuelle, et le NLP de manière générale, permet de comprendre et d'automatiser le traitement de tous types de langage et en ressortir des insight précis pour la gestion et la décision.

En fonction de la problématique énormément de méthodes existent et sont souvent assez longues et coûteuses. Le plus important pour mener à bien un projet est la compréhension et le travail conjoint avec les experts métiers. La mesure de la performance de ces modèles est en général assez subjective et donc les experts métiers sauront eux définir des choix pragmatiques au vu des résultats. Que ce soit pour de l'IA générative (chatbot etc.) ou du Topic Modelling (analyse de verbatims client etc.) le travail est itératif et fastidieux mais extrêmement riche en informations et s'il est bien fait riche en leviers actionnables et en gaine derrière.

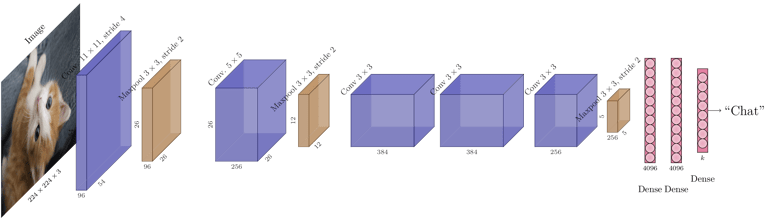

Analyse d'images

L'analyse d'images consiste à appliquer des techniques d'analyse statistique et de traitement d'images pour extraire des informations utiles à partir d'images numériques. Cela comprend la détection de motifs, la reconnaissance d'objets, la classification d'images et la segmentation d'images, entre autres techniques.

Ces méthodes permettent de comprendre le contenu et la structure des images, et sont utilisées dans de nombreux domaines tels que la vision par ordinateur, la médecine (par exemple, pour l'analyse d'images médicales), la surveillance, la reconnaissance de formes, l'industrie (contrôle qualité), l'automobile (véhicules autonomes), la sécurité, la reconnaissance de texte (OCR), l'astronomie, et bien d'autres encore. L'analyse d'images (ou de vidéos) permet de traiter des données visuelles de manière objective et quantitative, ce qui ouvre la voie à une multitude d'applications.

La technologie qui se cache derrière ce type de projet sont les fameux réseaux de neurones, ces outils statistiques sont très gourmands en données d'apprentissage. C'est pour cela que ces projets nécessitent en général de grosses masses de données qualifiées afin d'être mené à bien. Même si des méthodes permettent de contourner artificiellement ce problème ça ne vaut jamais de réels exemples d'images.

En résumé, l'analyse d'images vise à extraire des informations utiles à partir d'images numériques, ce qui ouvre la voie à de nombreuses applications pratiques et innovantes dans divers domaines.